Datenqualität und Repräsentation

Ausreißer, fehlende Werte und inkonsistente Labels kosten Leistung. In einem Vision‑Projekt verbesserte allein die Bereinigung von Label‑Leaks die Validierungs‑AUC um 6 Punkte. Teile deine bewährten Checks, mit denen du Datenfallen frühzeitig entlarvst.

Datenqualität und Repräsentation

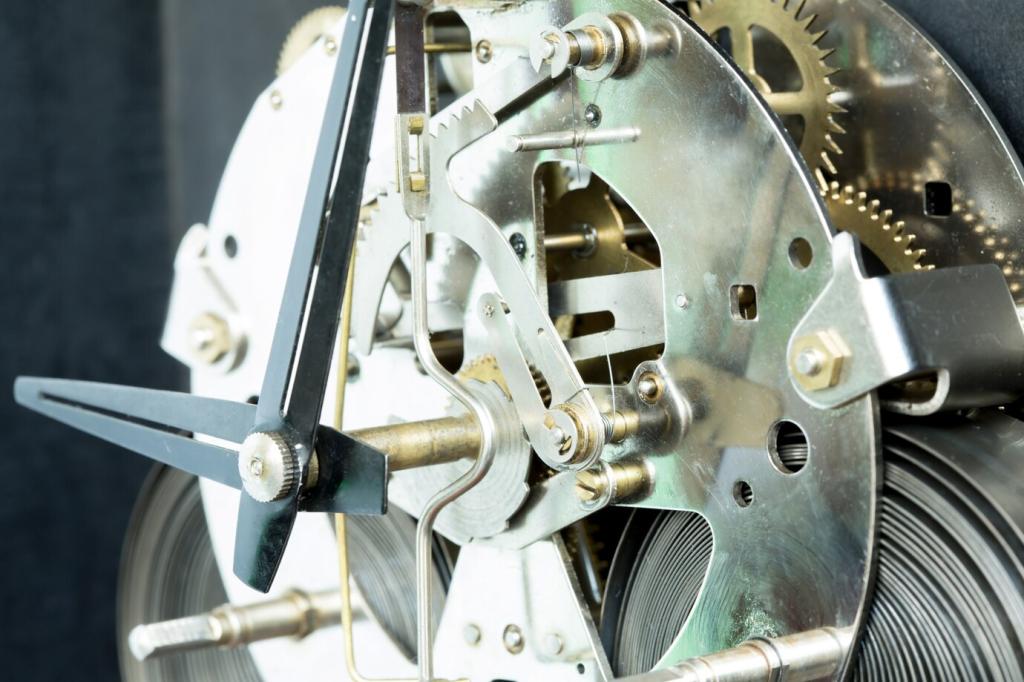

Domänenwissen kann Modelle erden, End‑to‑End‑Ansätze entdecken Muster, die Menschen übersehen. Oft gewinnt die Kombination: handverlesene Signale plus lernbare Repräsentationen. Welche Balance hat dir in komplexen, ressourcenarmen Projekten den besten Kompromiss ermöglicht?